Si formas parte de una organización que gestiona un servicio de retransmisión en directo y te has enfrentado a un aumento inesperado del tráfico o a una interrupción del servicio, es probable que tu equipo haya tenido que esforzarse por solucionar los problemas y los retrasos. Esta interrupción puede convertirse en un problema importante para los espectadores y en un enorme reto para su equipo.

La raíz del problema suele estar en la capacidad del proveedor de la nube para gestionar con eficacia los aumentos repentinos de tráfico y redirigirlo en caso de interrupción. Si el proveedor de la nube no es capaz de escalar los recursos con la suficiente rapidez para acomodar el aumento de la demanda, la plataforma de streaming puede ceder ante la presión, lo que provoca tiempos de inactividad, flujos lentos o incluso caídas completas.

Invirtiendo en infraestructura escalable, como servidores distribuidos y soluciones basadas en la nube, y aprovechando la computación de borde y una potente red de distribución de contenidos (CDN), puede garantizar que los usuarios disfruten de experiencias en directo ininterrumpidas, que los contenidos lleguen al espectador de forma fiable y que los servicios de streaming mantengan su reputación en un mundo cada vez más competitivo.

En este blog, repasaremos las herramientas que muchos de nuestros clientes utilizan para conseguir una retransmisión fiable.

Aprovechar los Puntos de Presencia de Akamai

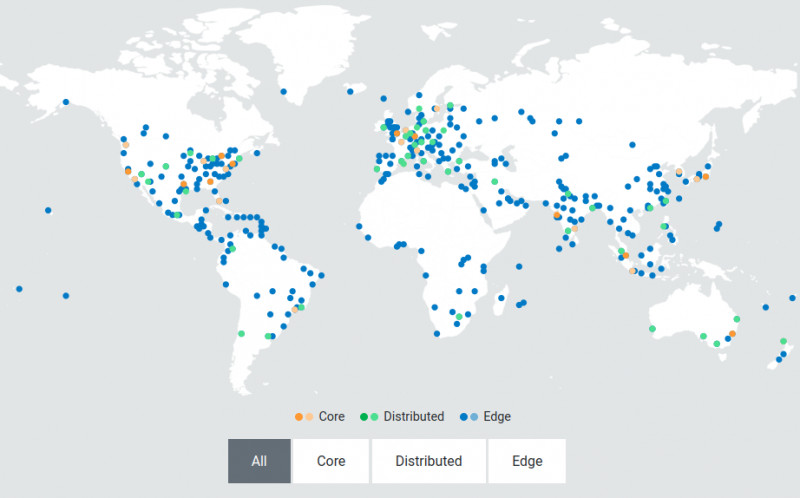

Una CDN como Akamai proporciona servidores edge descentralizados y localizados estratégicamente situados cerca de los usuarios finales. Los servidores edge actúan como puntos de presencia (PoP) que sirven como hubs intermediarios entre el centro de datos central y el dispositivo del usuario. Cuando el usuario solicita un vídeo, el contenido se entrega desde el servidor de borde más cercano en lugar de viajar desde el centro de datos central, de modo que cuando hay mucho tráfico, estos servidores pueden dividir y distribuir el contenido simultáneamente a usuarios de distintas regiones sin retrasos.

La imagen superior muestra la red distribuida de Akamai. Esta arquitectura está diseñada para escalar dinámicamente a fin de gestionar los picos de tráfico y las fluctuaciones de la demanda. Esta elasticidad garantiza que la infraestructura mantenga su capacidad de respuesta y resistencia, incluso en las condiciones más exigentes. Esta proximidad reduce significativamente el tiempo que tarda el contenido en llegar al dispositivo, lo que se traduce en una latencia más baja y una experiencia de streaming más fluida para los usuarios finales.

Cómo ayuda Akamai a los servicios de streaming en directo a lograr una baja latencia

Para ofrecer una experiencia de calidad a sus espectadores online, debe asegurarse de que sus máquinas virtuales no añaden latencia adicional a sus transmisiones en directo. Akamai soporta una latencia de 10 segundos de extremo a extremo para transmisiones en directo lineales y en directo. A continuación le mostramos cómo Akamai ayuda a los servicios de streaming en directo a conseguir una baja latencia:

- Transcodificación en directo en tiempo real

Un sistema de transcodificación en directo necesita escalarse para gestionar picos de carga de vídeo en tiempo real. Cualquier latencia añadida durante la transcodificación se transmite en última instancia al usuario final, lo que se traduce en una experiencia de visualización inferior a la óptima. - Segmentos de pequeño tamaño

La arquitectura de Akamai se creó para gestionar de forma fiable segmentos de pequeño tamaño (hasta 2 segundos) para streaming basado en HTTP para permitir a los reproductores reducir rápidamente las caídas de ancho de banda, evitar que los reproductores se paren y reducir de forma efectiva los buffers del lado del cliente. - Transferencias codificadas en trozos HTTP

La compatibilidad con transferencias codificadas en trozos desde la ingesta hasta el Edge para iniciar las transferencias en cuanto los datos estén disponibles ayuda a minimizar las latencias. - Precarga desde el borde

Los servidores de borde precargarán el siguiente conjunto de segmentos para una tasa de bits determinada y lo almacenarán en caché localmente mientras el segmento anterior ya se ha recibido y se está reproduciendo. Esto permite que los segmentos estén disponibles de inmediato y reduce el riesgo de latencia adicional.

Veamos cómo uno de nuestros clientes utilizó Akamai para escalar su streaming en directo con este proceso.

Cómo ampliar su servicio de retransmisión en directo en la periferia

Nuestro mecanismo de streaming en directo se consigue a través de los Servicios de Medios en Directo (MSL) de Akamai. MSL está diseñado para entregar eficientemente contenido de vídeo en directo a audiencias globales aprovechando la extensa red de servidores edge de Akamai distribuidos en diversas ubicaciones geográficas.

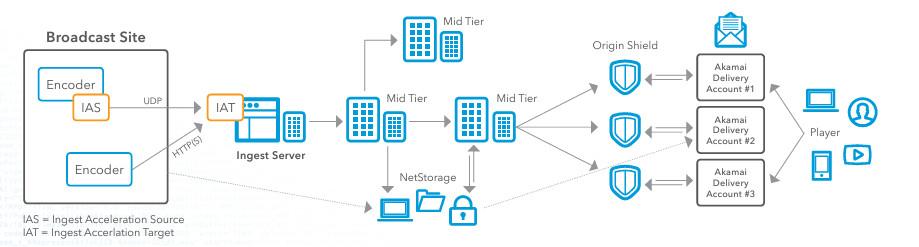

Echemos un vistazo a la arquitectura de referencia anterior que detalla tanto el flujo de trabajo de ingesta como el flujo de trabajo de entrega para un evento de streaming en directo con Akamai. Si está buscando mejorar sus servicios de streaming en directo, así es como sugeriría configurar MSL para gestionar el streaming en directo de un evento.

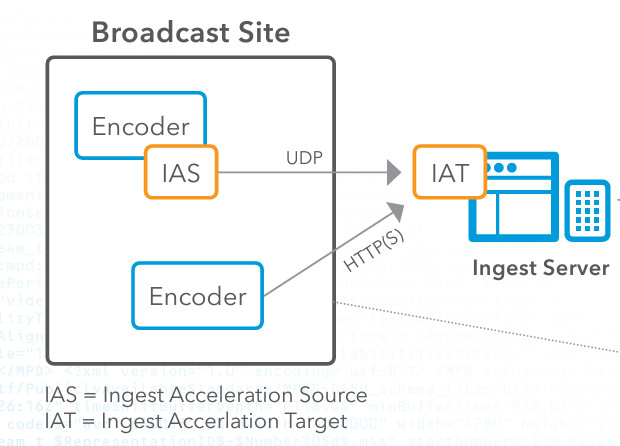

Paso 1: Codificación e ingestión

En primer lugar, hay que capturar el contenido de vídeo en directo en el lugar de emisión. Una vez que tenga el contenido, deberá configurar un codificador para convertir la señal de vídeo sin procesar en un formato digital, como HTTP Live Streaming (HLS) o Real-Time Messaging Protocol (RTMP). A continuación, utilizará el IAS (Ingest Acceleration Source) de Akamai, que se descarga a través del portal de clientes de Akamai. IAS toma el flujo del codificador y lo reenvía a través de nuestro protocolo de transporte UDP propietario. A continuación, debe configurar la IAS para recibir el flujo desde el codificador.

A continuación, es necesario configurar el Ingest Acceleration Target (IAT) en la red de Akamai y asegurarse de que el IAT está configurado para descodificar el flujo a su formato original. A continuación, conectamos el IAT al software de punto de entrada de Akamai para su posterior procesamiento. En esta fase de codificación e ingestión, muchas personas se enfrentan al problema de la pérdida de paquetes. El streaming de vídeo en directo es muy sensible a la pérdida de paquetes, que puede degradar la calidad de la transmisión, causar almacenamiento en búfer y provocar una experiencia de visualización insatisfactoria. Sin embargo, los clientes que utilizan Akamai para el streaming en directo no experimentan esto porque la tecnología de aceleración basada en UDP que utiliza Akamai ayuda a mitigar los efectos de la pérdida de paquetes asegurando que los paquetes de datos se entreguen de forma más fiable y rápida, incluso en condiciones de red inestables. Otra razón por la que esta tecnología es crucial en el proceso de streaming en directo es que la transmisión tradicional basada en TCP puede sufrir una alta latencia debido a sus mecanismos de control de congestión y corrección de errores. El streaming en directo requiere una baja latencia para garantizar que los espectadores reciban el contenido en tiempo real. La aceleración basada en UDP de Akamai proporciona un mayor rendimiento y una menor latencia al minimizar estos gastos generales, lo cual es crucial para el contenido en directo, donde la entrega a tiempo es esencial.

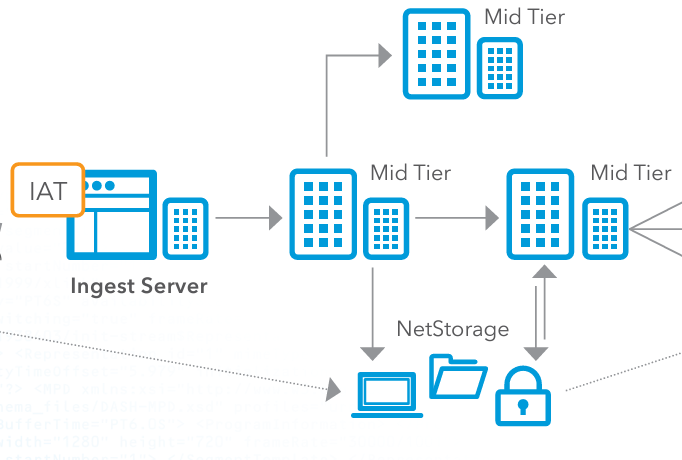

Paso 2: Distribución de nivel medio y almacenamiento opcional

A continuación, debe dirigir el flujo de vídeo procesado a los servidores de nivel medio de Akamai. Estos servidores actúan como intermediarios entre el servidor de ingesta y la red de entrega edge. Los servidores de nivel medio distribuyen el flujo de vídeo, asegurándose de que se replica y se almacena en caché en varios puntos de la red para equilibrar la carga y mejorar la redundancia. Cuando un proveedor de nube gestiona el streaming en directo, es importante que este equilibrio de carga se gestione correctamente, porque si no, se producirán cuellos de botella en el proceso. Cuando se utiliza la red de entrega Edge de Akamai, se evita que un solo servidor se convierta en un cuello de botella, garantizando que ningún servidor individual se vea desbordado por demasiadas solicitudes. Esto es especialmente importante durante eventos de alto tráfico.

Opcionalmente, puede almacenar el contenido de vídeo en el sistema NetStorage de Akamai. NetStorage garantiza que el contenido esté siempre disponible y pueda recuperarse rápidamente en caso necesario. Esto proporciona una solución de almacenamiento escalable y segura que puede servir como copia de seguridad o para la reproducción bajo demanda.

Paso 3: Escudo de origen

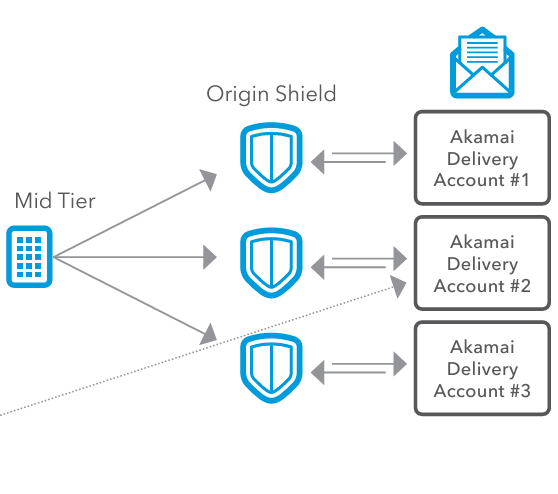

A continuación, enviamos el vídeo a Origin Shield, que ayuda a gestionar los picos de tráfico actuando como amortiguador entre los servidores de ingesta y la CDN de Akamai. Durante las horas punta o los aumentos inesperados de espectadores, Origin Shield puede gestionar el aumento de carga, evitando que los servidores de ingesta se saturen. Esto garantiza que el sistema pueda acomodar a un gran número de espectadores sin degradar el rendimiento. Origin Shield también optimiza la eficiencia de la caché. Al añadir una capa adicional de almacenamiento en caché, Origin Shield reduce la frecuencia con la que las solicitudes tienen que volver a los servidores de origen. Esto disminuye la carga en los servidores de origen, conserva el ancho de banda y acelera la entrega de contenidos a los usuarios finales. Para los usuarios finales, esto se traduce en un acceso más rápido a los contenidos, reduciendo la latencia y mejorando la experiencia del espectador.

Paso 4: Configuración de la entrega y entrega al usuario final

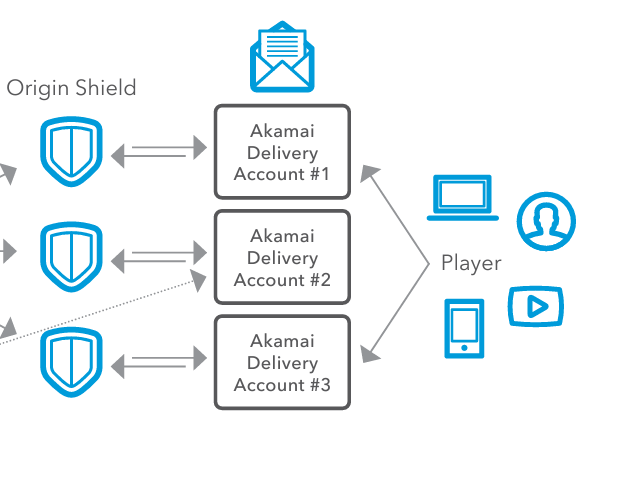

Ahora, es el momento de distribuir el contenido. Cuando se distribuye el contenido globalmente a diferentes regiones, pueden variar las condiciones de la red, los requisitos normativos o las preferencias de los espectadores. Para resolver esto, nuestros clientes utilizan las Cuentas de Entrega de Akamai. Las Cuentas de Entrega de Akamai corresponden a diferentes configuraciones y configuraciones para entregar el contenido y permiten a los proveedores de contenido configurar diferentes ajustes, como políticas de almacenamiento en caché, protocolos de seguridad y optimizaciones de entrega específicas para cada región. Cada cuenta de entrega puede tener ajustes específicos adaptados a las necesidades de varias regiones, dispositivos o tipos de contenido. Esto es importante porque los proveedores de contenidos necesitan distribuir sus contenidos de forma eficaz y flexible a través de múltiples canales de distribución.

Por último, el contenido de vídeo se entrega a los usuarios finales a través de diversos dispositivos, como ordenadores, teléfonos inteligentes, tabletas y televisores inteligentes. Los servidores de borde entregan el flujo de vídeo al dispositivo del reproductor con una latencia mínima, lo que garantiza una experiencia de visualización fluida y de alta calidad.

Conclusión

A la hora de crear una solución de retransmisión en directo hay que tener en cuenta muchas cosas. En primer lugar, hay que tener en cuenta la latencia y el almacenamiento en búfer, especialmente durante los eventos en directo, donde la transmisión en tiempo real es fundamental. Una latencia alta puede provocar retrasos en la retransmisión en directo, lo que hará muy infelices a los usuarios finales. También hay que tener en cuenta la pérdida de paquetes, que puede degradar la calidad del vídeo o provocar interrupciones. Con la pérdida de paquetes, los usuarios finales se enfrentarán a flujos incoherentes y poco fiables, lo que provocará una mala experiencia visual. Por último, hay que ser capaz de escalar y equilibrar la carga. Podría enfrentarse a sobrecargas y caídas del servidor, lo que provocaría interrupciones del servicio y una incapacidad para gestionar los picos de carga de forma eficiente. La red de entrega optimizada de Akamai resuelve todos estos problemas mediante su aceleración basada en UDP, su red de ingestión y su CDN escalable.

El uso de Akamai para el streaming en directo garantiza una entrega eficiente, escalable y de baja latencia de las transmisiones de vídeo en directo, proporcionando una gran experiencia a los usuarios finales. Al acercar la potencia de procesamiento al extremo de la red con Akamai, los servicios de streaming pueden optimizar el rendimiento y mejorar la escalabilidad.

Para seguir un tutorial paso a paso sobre transcodificación de vídeo, siga este enlace para convertir un archivo mp4 a formato HLS. También puede consultar nuestra documentación sobre la API de aprovisionamiento de flujos en directo de servicios multimedia.

Para saber más sobre cómo ponerlo en práctica usted mismo, conéctese con nosotros en Twitter o LinkedIn, o suscríbase a nuestro canal de YouTube.

Si usted o su organización están considerando optimizar sus soluciones de transcodificación de vídeo y Kubernetes, puede probar las soluciones de Linoderegistrándose para obtener 100 dólares en créditos gratuitos.

Comentarios