Wenn Sie zu einer Organisation gehören, die einen Live-Streaming-Dienst betreibt, und Sie mit einem unerwarteten Anstieg des Datenverkehrs oder einem Ausfall konfrontiert waren, musste Ihr Team sich wahrscheinlich mit der Fehlersuche und der Behebung von Verzögerungen herumschlagen. Diese Unterbrechung kann für die Zuschauer zu einem erheblichen Problem und für Ihr Team zu einer großen Herausforderung werden.

Die Ursache des Problems liegt oft in der Fähigkeit Ihres Cloud-Anbieters, plötzliche Anstiege des Datenverkehrs effektiv zu bewältigen und den Datenverkehr im Falle eines Ausfalls umzuleiten. Gelingt es dem Cloud-Anbieter nicht, die Ressourcen schnell genug zu skalieren, um der gestiegenen Nachfrage gerecht zu werden, kann die Streaming-Plattform unter dem Druck zusammenbrechen, was zu Ausfallzeiten, verzögerten Streams oder sogar kompletten Abstürzen führt.

Durch Investitionen in eine skalierbare Infrastruktur, wie verteilte Server und Cloud-basierte Lösungen, sowie die Nutzung von Edge Computing und einem leistungsstarken Content Delivery Network (CDN) können Sie sicherstellen, dass die Nutzer ununterbrochene Live-Erlebnisse genießen, die Inhalte den Zuschauer zuverlässig erreichen und die Streaming-Dienste ihren Ruf in einer zunehmend wettbewerbsorientierten Welt wahren.

In diesem Blog stellen wir Ihnen die Tools vor, die viele unserer Kunden für zuverlässiges Streaming nutzen.

Die Vorteile der Akamai-Punkte der Präsenz nutzen

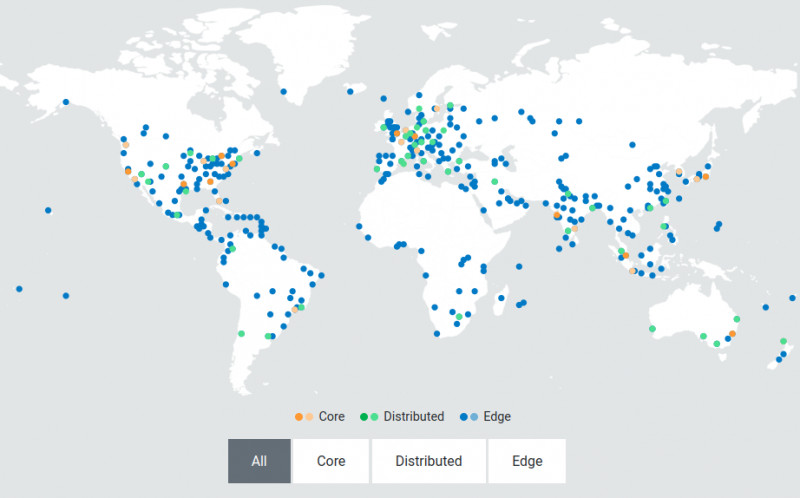

Ein CDN wie Akamai bietet dezentralisierte und lokalisierte Edge-Server, die strategisch in unmittelbarer Nähe der Endnutzer positioniert sind. Edge-Server fungieren als Points of Presence (PoPs), die als zwischengeschaltete Knotenpunkte zwischen dem zentralen Datenzentrum und dem Gerät des Nutzers dienen. Wenn Sie ein Video anfordern, wird der Inhalt vom nächstgelegenen Edge-Server geliefert, anstatt den ganzen Weg vom zentralen Datenzentrum zurückzulegen. Bei hohem Datenverkehr können diese Server den Inhalt aufteilen und gleichzeitig an Benutzer in verschiedenen Regionen ohne Verzögerungen verteilen.

Das obige Bild zeigt das verteilte Netzwerk von Akamai. Diese Architektur ist so konzipiert, dass sie dynamisch skaliert werden kann, um Verkehrsspitzen und Nachfrageschwankungen zu bewältigen. Diese Elastizität sorgt dafür, dass die Infrastruktur auch unter den anspruchsvollsten Bedingungen reaktionsschnell und belastbar bleibt. Durch diese Nähe wird die Zeit, die der Inhalt benötigt, um Ihr Gerät zu erreichen, erheblich verkürzt, was zu geringeren Latenzzeiten und einem reibungsloseren Streaming-Erlebnis für die Endbenutzer führt.

Wie Akamai Live-Streaming-Dienste zu niedrigen Latenzzeiten verhilft

Um Ihren Online-Zuschauern ein hochwertiges Erlebnis zu bieten, müssen Sie sicherstellen, dass Ihre VMs keine zusätzliche Latenz zu Ihren Live-Streams hinzufügen. Akamai unterstützt eine End-to-End-Latenz von 10 Sekunden für lineare und Live-Streams. Hier erfahren Sie, wie Akamai Live-Streaming-Dienste dabei unterstützt, niedrige Latenzzeiten zu erreichen:

- Live-Transkodierung in Echtzeit

Ein Live-Transkodierungssystem muss so skaliert werden, dass es Spitzenwerte bei der Videolast in Echtzeit verarbeiten kann. Jede während der Transkodierung hinzugefügte Latenzzeit wird letztendlich an den Endbenutzer weitergegeben, was zu einem nicht optimalen Seherlebnis führt. - Kleine Segmentgrößen

Die Architektur von Akamai wurde entwickelt, um kleine Segmentgrößen (bis zu 2 Sekunden) für HTTP-basiertes Streaming zuverlässig zu handhaben, damit die Player bei Bandbreitenabfällen schnell umschalten, einen Stillstand der Player verhindern und die clientseitigen Puffer effektiv reduzieren können. - HTTP chunked encoded transfers

Die Unterstützung von chunked encoded transfers vom Ingest bis zum Edge, um Übertragungen zu initiieren, sobald die Daten verfügbar sind, trägt zur Minimierung von Latenzen bei. - Vorabruf vom Edge

Edge-Server rufen den nächsten Satz von Segmenten für eine bestimmte Bitrate vorab ab und speichern ihn lokal zwischen, während das vorherige Segment bereits empfangen und abgespielt wird. Dadurch sind die Segmente sofort verfügbar und das Risiko zusätzlicher Latenzzeiten wird verringert.

Sehen wir uns an, wie einer unserer Kunden Akamai zur Skalierung seines Live-Streamings mit diesem Verfahren eingesetzt hat.

So skalieren Sie Ihren Live-Streaming-Dienst am Rand

Unser Live-Streaming-Mechanismus wird durch die Media Services Live (MSL) von Akamai realisiert. MSL wurde entwickelt, um Live-Videoinhalte effizient an ein globales Publikum zu liefern, indem das umfangreiche Netzwerk von Akamai-Edge-Servern genutzt wird, die über verschiedene geografische Standorte verteilt sind.

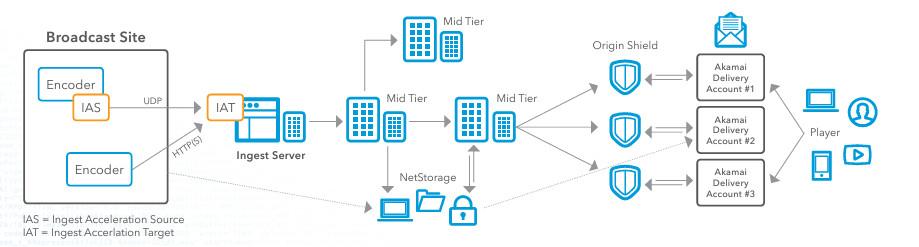

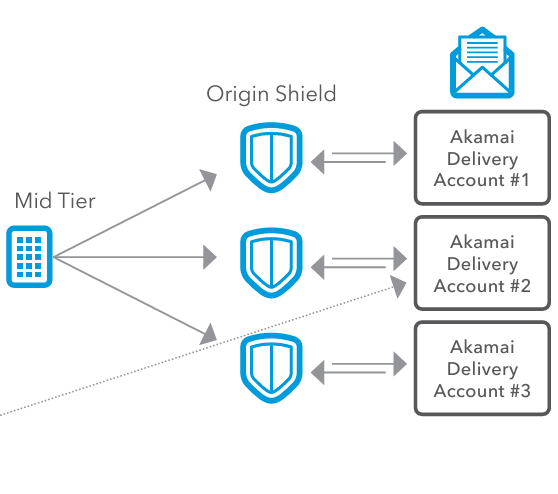

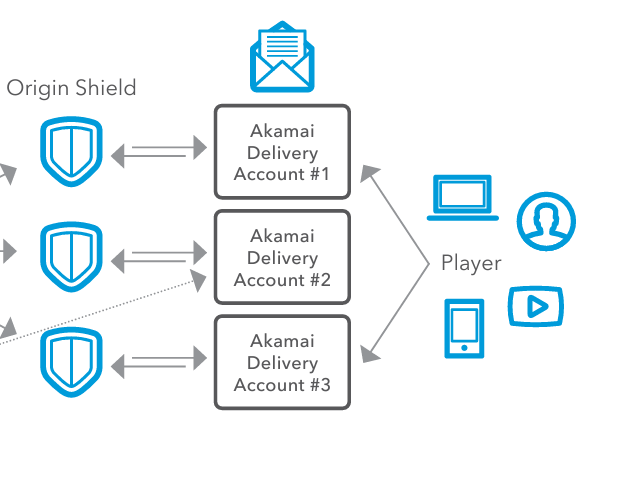

Werfen wir einen Blick auf die obige Referenzarchitektur, die sowohl den Ingest-Workflow als auch den Delivery-Workflow für ein Live-Streaming-Event mit Akamai beschreibt. Wenn Sie Ihre Live-Streaming-Dienste verbessern möchten, empfehle ich Ihnen, MSL so einzurichten, dass es das Live-Streaming einer Veranstaltung verarbeiten kann.

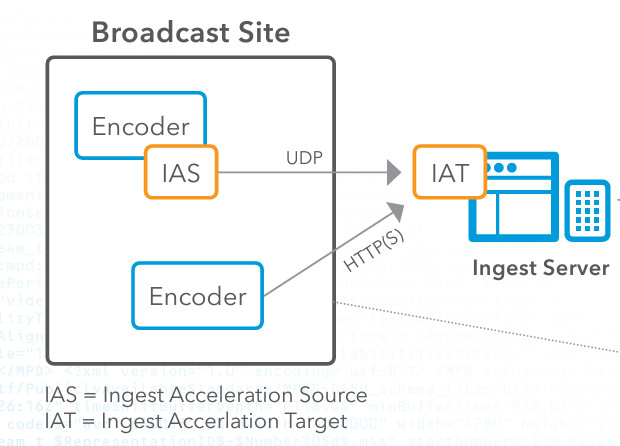

Schritt 1: Kodierung und Einspeisung

Zunächst müssen Sie die Live-Videoinhalte am Übertragungsort erfassen. Sobald Sie die Inhalte haben, müssen Sie einen Encoder einrichten, um den rohen Video-Feed in ein digitales Format wie HTTP Live Streaming (HLS) oder Real-Time Messaging Protocol (RTMP) zu konvertieren. Anschließend verwenden Sie die IAS (Ingest Acceleration Source) von Akamai, die Sie über das Kundenportal von Akamai herunterladen können. IAS übernimmt den Stream vom Encoder und leitet ihn über unser proprietäres UDP-Transportprotokoll weiter. Anschließend müssen Sie die IAS für den Empfang des Streams vom Encoder konfigurieren.

Als Nächstes müssen Sie das Ingest Acceleration Target (IAT) im Netzwerk von Akamai einrichten und sicherstellen, dass das IAT so konfiguriert ist, dass es den Stream in sein ursprüngliches Format zurückdekodiert. Anschließend verbinden wir das IAT zur weiteren Verarbeitung mit der Entry Point Software von Akamai. In dieser Kodierungs- und Ingestion-Phase stehen viele Menschen vor dem Problem des Paketverlusts. Live-Videostreaming reagiert sehr empfindlich auf Paketverluste, die die Qualität des Streams verschlechtern, Pufferung verursachen und zu einem unbefriedigenden Seherlebnis führen können. Kunden, die Akamai für Live-Streaming nutzen, haben damit jedoch keine Probleme, da die von Akamai verwendete UDP-basierte Beschleunigungstechnologie die Auswirkungen von Paketverlusten abmildert, indem sie dafür sorgt, dass Datenpakete zuverlässiger und schneller zugestellt werden, selbst bei instabilen Netzwerkbedingungen. Ein weiterer Grund, warum diese Technologie für den Live-Streaming-Prozess so wichtig ist, ist die Tatsache, dass die herkömmliche TCP-basierte Übertragung aufgrund der Staukontrolle und der Fehlerkorrekturmechanismen eine hohe Latenz aufweisen kann. Live-Streaming erfordert eine niedrige Latenzzeit, um sicherzustellen, dass die Zuschauer die Inhalte in Echtzeit empfangen. Die UDP-basierte Beschleunigung von Akamai sorgt für einen höheren Durchsatz und eine geringere Latenzzeit, indem sie diese Overheads minimiert, was für Live-Inhalte, bei denen eine zeitnahe Auslieferung entscheidend ist, entscheidend ist.

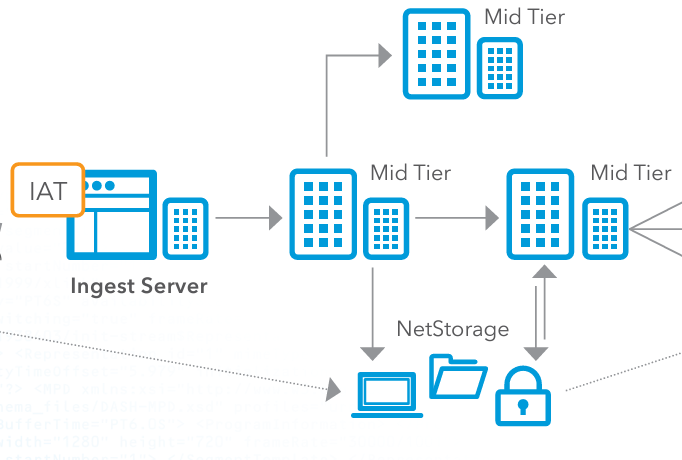

Schritt 2: Mid-Tier-Verteilung und optionale Speicherung

Als nächstes müssen Sie den verarbeiteten Videostream an die Mid-Tier-Server von Akamai weiterleiten. Diese Server fungieren als Vermittler zwischen dem Ingest-Server und dem Edge Delivery Network. Die Mid-Tier-Server verteilen den Videostream weiter und sorgen dafür, dass er an mehreren Punkten im Netzwerk repliziert und zwischengespeichert wird, um die Last auszugleichen und die Redundanz zu verbessern. Wenn ein Cloud-Anbieter das Live-Streaming abwickelt, ist es wichtig, dass dieser Lastausgleich korrekt gehandhabt wird, da es andernfalls zu Engpässen im Prozess kommt. Wenn Sie das Edge-Delivery-Netzwerk von Akamai nutzen, verhindern Sie, dass ein einzelner Server zu einem Engpass wird, und stellen sicher, dass kein einzelner Server durch zu viele Anfragen überlastet wird. Dies ist besonders wichtig bei Ereignissen mit hohem Verkehrsaufkommen.

Optional können Sie die Videoinhalte im NetStorage-System von Akamai speichern. NetStorage stellt sicher, dass die Inhalte immer verfügbar sind und bei Bedarf schnell abgerufen werden können. Dies bietet eine skalierbare, sichere Speicherlösung, die als Backup oder für die On-Demand-Wiedergabe dienen kann.

Schritt 3: Herkunftsschutzschild

Als Nächstes senden wir das Video an Origin Shield, das als Puffer zwischen den Ingest-Servern und dem Akamai CDN fungiert und so hilft, Verkehrsspitzen zu bewältigen. In Spitzenzeiten oder bei unerwarteten Anstiegen der Zuschauerzahlen kann Origin Shield die erhöhte Last bewältigen und verhindert, dass die Ingest-Server überlastet werden. Dadurch wird sichergestellt, dass das System eine große Anzahl von Zuschauern ohne Leistungseinbußen aufnehmen kann. Origin Shield optimiert auch die Cache-Effizienz. Durch das Hinzufügen einer zusätzlichen Zwischenspeicherebene reduziert Origin Shield die Häufigkeit, mit der Anfragen zu den Ursprungsservern zurückkehren müssen. Dies verringert die Last auf den Ursprungsservern, schont die Bandbreite und beschleunigt die Bereitstellung von Inhalten für die Endbenutzer. Für die Endnutzer bedeutet dies einen schnelleren Zugriff auf die Inhalte, geringere Latenzzeiten und ein besseres Nutzererlebnis.

Schritt 4: Konfiguration der Auslieferung und Auslieferung an den Endbenutzer

Nun ist es an der Zeit, die Inhalte zu verbreiten. Wenn Sie die Inhalte weltweit in verschiedene Regionen verteilen, können unterschiedliche Netzwerkbedingungen, gesetzliche Anforderungen oder Zuschauerpräferenzen vorliegen. Um dieses Problem zu lösen, verwenden unsere Kunden Akamai Delivery Accounts. Akamai Delivery Accounts entsprechen verschiedenen Konfigurationen und Setups für die Auslieferung der Inhalte und ermöglichen es Content-Providern, verschiedene Einstellungen wie Caching-Richtlinien, Sicherheitsprotokolle und Auslieferungsoptimierungen speziell für jede Region zu konfigurieren. Jedes Bereitstellungskonto kann über spezifische Einstellungen verfügen, die auf die Anforderungen verschiedener Regionen, Geräte oder Inhaltstypen zugeschnitten sind. Dies ist wichtig, da Content-Provider ihre Inhalte effizient und flexibel über verschiedene Bereitstellungskanäle verteilen müssen.

Schließlich werden die Videoinhalte den Endnutzern über eine Vielzahl von Geräten wie Computer, Smartphones, Tablets und Smart-TVs zur Verfügung gestellt. Die Edge-Server liefern den Videostream mit minimaler Latenz an das Gerät des Spielers und sorgen so für ein reibungsloses und hochwertiges Seherlebnis.

Fazit

Beim Aufbau einer Live-Streaming-Lösung sind viele Dinge zu berücksichtigen. Erstens müssen Sie Latenz und Pufferung berücksichtigen, vor allem bei Live-Veranstaltungen, bei denen die Echtzeitübertragung entscheidend ist. Eine hohe Latenz kann zu Verzögerungen bei der Live-Übertragung führen, was Ihre Endbenutzer sehr unzufrieden machen wird. Sie müssen auch für Paketverluste vorsorgen, die die Videoqualität beeinträchtigen oder Unterbrechungen verursachen können. Bei Paketverlusten haben Ihre Endbenutzer mit inkonsistenten und unzuverlässigen Streams zu kämpfen, was zu einem schlechten Seherlebnis führt. Und schließlich müssen Sie in der Lage sein, die Last zu skalieren und auszugleichen. Es kann zu Serverüberlastungen und -abstürzen kommen, was zu Serviceausfällen führt und dazu, dass Sie Spitzenlasten nicht effizient bewältigen können. Das optimierte Bereitstellungsnetzwerk von Akamai löst all diese Probleme durch seine UDP-basierte Beschleunigung, sein Ingestion-Netzwerk und sein skalierbares CDN.

Der Einsatz von Akamai für Live-Streaming gewährleistet eine effiziente, skalierbare und latenzarme Bereitstellung von Live-Videostreams und bietet den Endnutzern ein hervorragendes Erlebnis. Indem Akamai die Verarbeitungsleistung näher an den Rand des Netzwerks bringt, können Streaming-Dienste die Leistung optimieren und die Skalierbarkeit verbessern.

Eine Schritt-für-Schritt-Anleitung zur Videotranskodierung finden Sie unter diesem Link, um eine mp4-Datei in das HLS-Format zu konvertieren. Sie können auch unsere Dokumente über die Media Services Live Stream Provisioning API lesen.

Wenn Sie mehr darüber erfahren möchten, wie Sie dies selbst umsetzen können, setzen Sie sich mit uns auf Twitter oder LinkedIn in Verbindung, oder abonnieren Sie unseren YouTube-Kanal.

Wenn Sie oder Ihr Unternehmen darüber nachdenken, seine Videotranskodierungs- und Kubernetes-Lösungen zu optimieren, können Sie die Lösungen von Linode testen, indem Sie sich anmelden und 100 US-Dollar an kostenlosen Credits erhalten.

Kommentare